大创项目前期规划

脑机接口(BCI)与VR技术的融合与应用 项目前期规划

总体规划

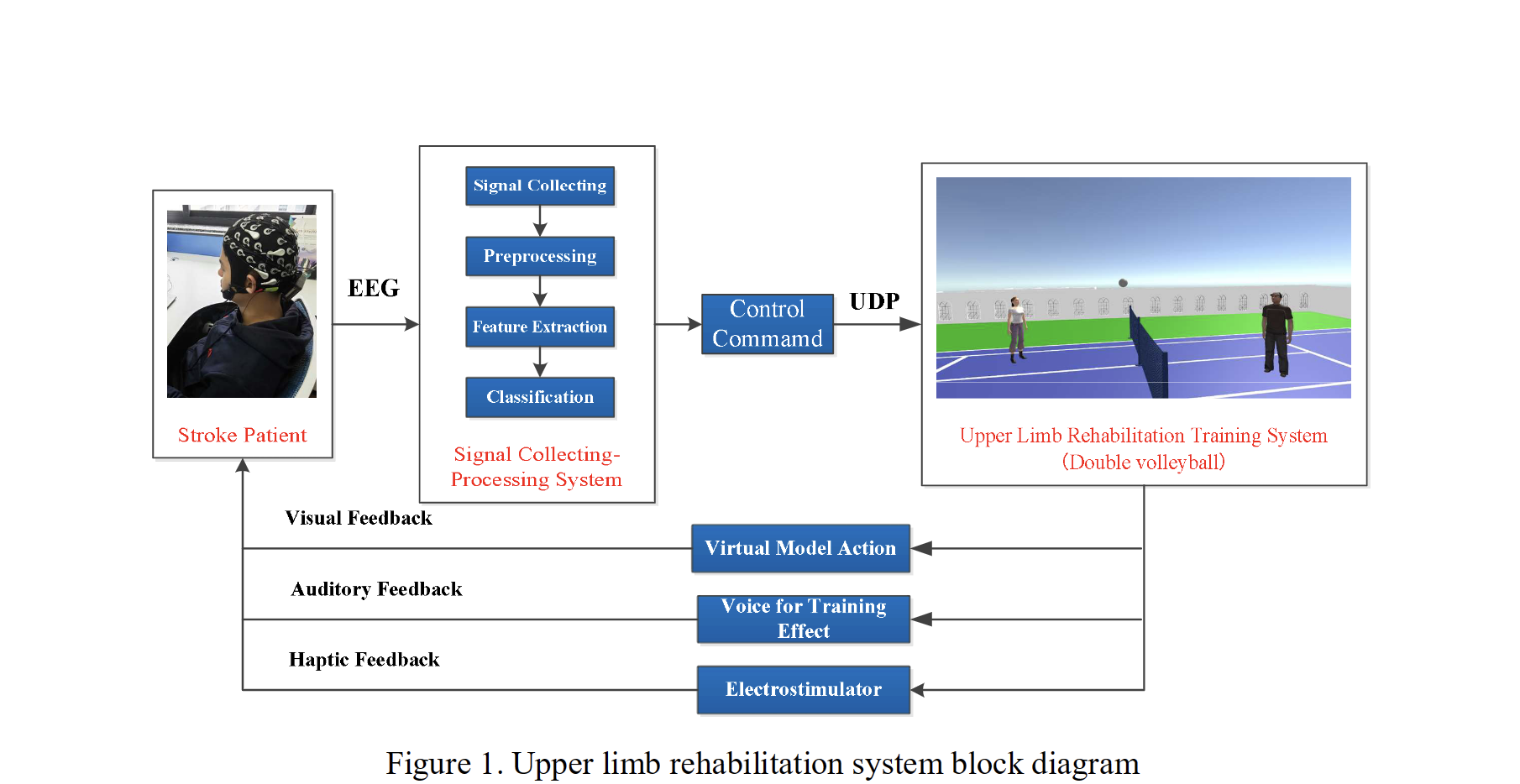

上图所示的是使用VR和基于运动想象的脑机接口(MI-BCI)技术搭建的一个用于上肢的康复训练场景. 对于部分中风患者, 已经不能直接通过大脑控制移动自己的手臂, 但是可以证明其控制手臂的大脑信号仍然正常, 因此可以通过脑机读取相应的脑电信号, 识别出患者想要移动手臂的运动意图, 在VR构造的虚拟场景中, 挥动双臂, 像正常人一样打排球. 这样的交互模式有助于现实世界中重塑患者对双手的控制, 从而帮助患者康复训练.

除了康复训练, BCI-VR的其他应用场景也具有与上图相似的范式. 具体来说, 都是首先通过读取EEG脑电信号, 经过信号处理识别算法后, 识别用户的意图, 再将其作为输入, 参与到VR的应用交互中, VR会根据大脑的意图作出相应的反馈.

因此, 从实现路径来说, 分为以下几步:

- [准备阶段]查阅相关文献/emotiv文档/相关识别算法

- 实现EEG信号的大脑意图识别(运动意图/情感的识别) ✨

- 实现将EEG信号导入VR应用的接口

- 实现VR交互的场景/交互模式构建

实现EEG信号的大脑意图识别(运动意图/情感的识别)

这部分应该是整个项目比较fundamental的部分, 也是个人认为最重要的部分, 因此前中期主要会在这个阶段. 这个阶段的关键在于AI识别算法(如KNN, SVM等), 实现从原生的EEG信号转化为具体的意图, 例如:

- 实现运动方向(前后左右)的识别, 可以用于在虚拟场景中的移动(navigation).

- 实现情感的识别(positive/neutral/negative), 作为VR交互的全新维度.

实现将EEG信号导入VR应用的接口

由于上个阶段代码工作主要基于python实现, 而VR应用主要基于Unity开发, 因此需要实现软件层面的接口, 将从EEG设备读取并识别后的意图输入VR设备.

实现VR交互的场景/交互模式构建

这个阶段可以认为是一个Demo的阶段, 是将BCI技术的结果在VR场景中使用, 来增强VR的交互能力, 如上文提到, 实现hands-free navigation, 即在虚拟场景中直接通过大脑想象实现移动, 而不需要使用者真实移动; 此外, 可以在用户佩戴VR设备时实时读取脑电信号识别情感和放松程度, 来调整VR的显示内容等.

上述的只是笔者目前想到的两种可行的应用场景, 一定还有许多有价值、有意思的场景, 因此具体的VR交互模式还有待构想.